أعلنت OpenAI عن نموذجها الجديد لتحويل النص إلى فيديو وسمته Sora (سورا وتعني سماء باليابانية)؛ و الذي يمتلك القدرة على توليد مقطع فيديو تصل مدته كحد أقصى إلى 60 ثانية وبدقة عالية الجودة FHD.

عرضت الشركة فيديوهات مختارة بعناية توضح فيها نتائج النموذج الذي يبدو أنه يتفوق فيها على الكثير مما شاهدناه سابقاً باستثناء نموذج Gen-2 من شركة RunWay.

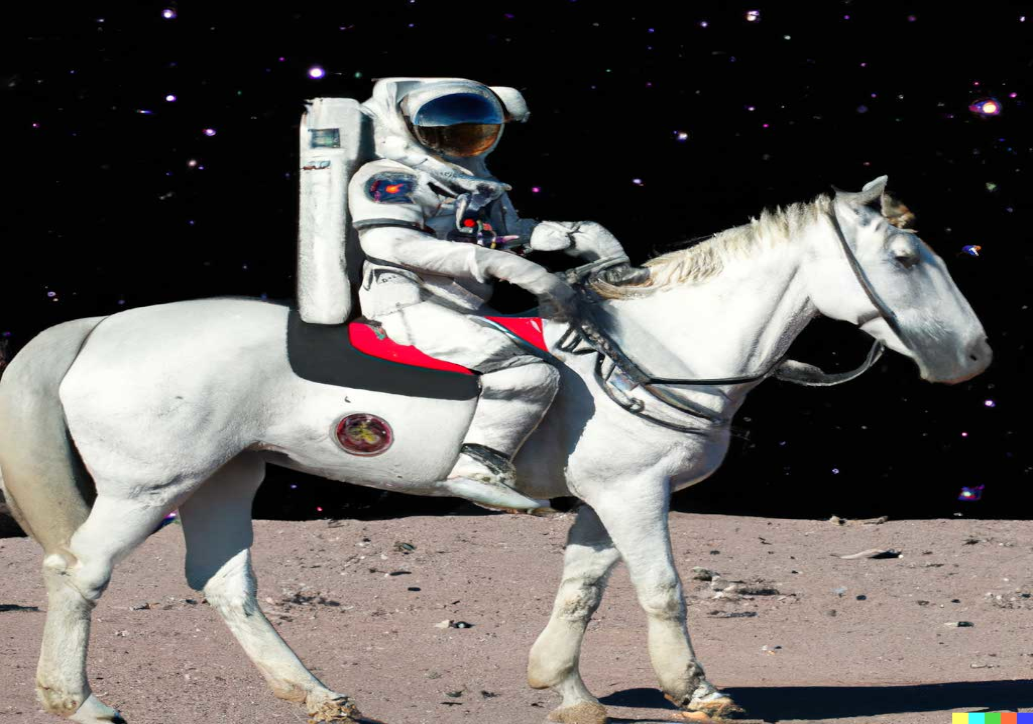

يتميز النموذج بتوليد مقاطع فيديو منسجمة و تعبر مباشرة عن النص وتحتوي عدة شخصيات يمكن تحريكها باتجاهات مختلفة مع مراعاة تموضع الأشياء في الفيديو بطريقة منطقية؛ أي أن للنموذج بعض الفهم لفيزياء حركة الأشياء في العالم المادي.

لكن رغم ذلك تقر الشركة بأن Sora قد لايعطي دائماً نتائج كما هو متوقع منه و يرتكب حماقات غريبة في بعض الأحيان وتبين بعض الأمثلة على ذلك: كأن ينفخ شخص على شمعة لا تنطفئ أو يقضم قطعة حلوى فلا تظهر آثار القضم.

بعض الأمثلة: "لقطات تاريخية لكاليفورنيا أثناء فترة حمى الذهب"

من يستطيع استخدامه اليوم؟

النموذج متاح لعدد محدود من المصممين وصناع الأفلام لكي يقوموا بتجربته والاستفادة من ملاحظاتهم لتحسين وتطوير النموذج قبل أن يصبح متاحاً للعموم.

سباق متسارع

وبهذا تنضم OpenAI إلى شركات ناشئة تعمل على توليد الفيديو من وصف نصي وأشهرهم RunWay أو عمالقة التكنولوجيا مثل ميتا وغوغل وأنفيديا.

فميتا تعمل على نموذج اسمه Text-a-Video وغوغل خطت خطوات هامة في نموذجها Lumiere وربما ستكون المقارنة مع غوغل أكثر مباشرة لأن المنافسة بين الشركتين قائمة بين نموذجهما اللغوي ChatGPT و جيمناي ونموذجهما لتوليد الصور من نص دالي3 و إيماجن والآن تتوسع لتشمل مجال توليد الفيديو أيضاً.