تعدّ غوغل من أهمّ اللاعبين في مجال الذكاء الاصطناعي، حيث طورت شركة ديب-مايند التابعة لها برنامج ألفاغو الذي تغلّب عام 2016 على بطل العالم في لعبة غو، وهي لعبة مشهورة بتعقيدها الكبير وعمقها الاستراتيجي. كما طورت غوغل إطار العمل TensorFlow الذي يُمكّن الباحثين والمطورين من تطوير برامج الذكاء الاصطناعي بسهولة وكفاءة.

لم تكتفِ غوغل بتطوير الجانب البرمجي، بل طورت أيضاً وحدات معالجة جديدة تعرف باسم TPUs لتسريع عملية تدريب وتشغيل نماذج الذكاء الاصطناعي الكبيرة التي تتطلب عدداً ضخماً من العمليات الحسابية المتوازية وتستهلك الكثير من الطاقة عند استخدام وحدات معالجة تقليدية مثل GPU و CPU.

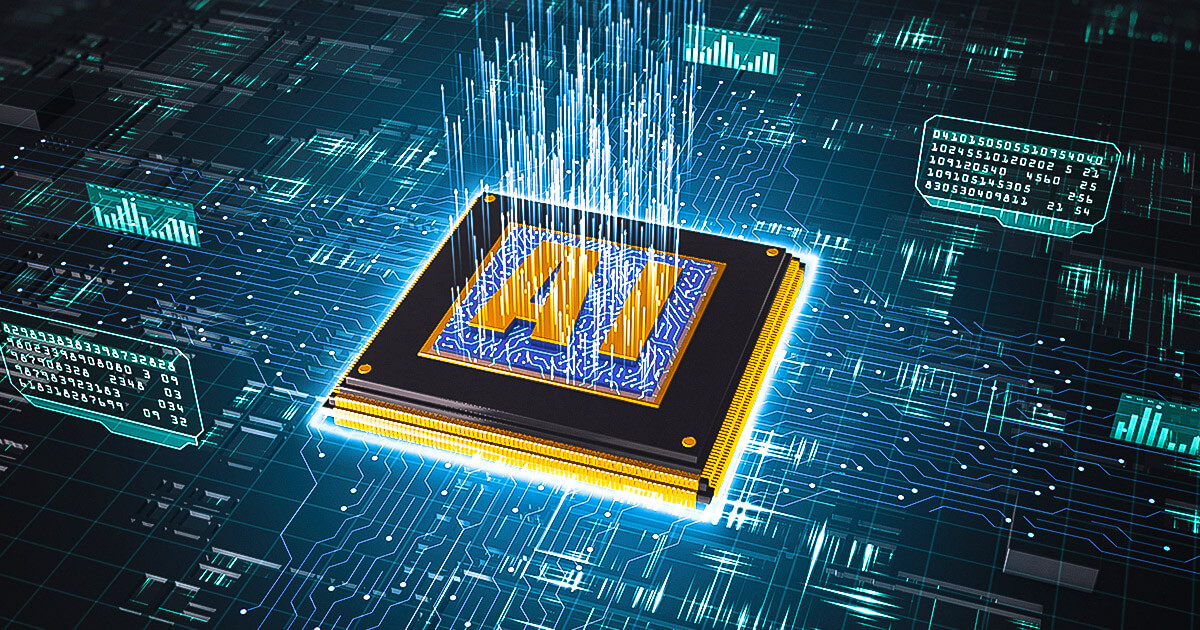

ماهي TPUs؟

وحدات TPU، أو Tensor Processing Units عبارة عن شرائح مصممة خصيصاً لتسريع مهام التعلم الآلي، وخاصة تلك التي تستخدم في عملها الشبكات العصبونية (أو التعلم العميق). إذ تراعي في تصميمها تسريع إنجاز العمليات الحسابية التي تتطلبها نماذج الذكاء الاصطناعي وتوفير في الطاقة اللازمة لتنفيذها. تم تطويرها لأول مرة للاستخدام الداخلي في غوغل في عام 2015، ثم أصبحت متاحة للاستخدام على نطاق واسع في عام 2018 من خلال خدمة جوجل السحابية؛ ثم تم توفيرها للأجهزة الطرفية الصغيرة بحجم أصغر منذ عام 2019.

لماذا تطورها غوغل؟

من الشائع استخدام وحدات الـ GPU في تدريب وتشغيل نماذج الذكاء الاصطناعي الحديثة وهي مناسبة لإجراء العمليات على التوازي مثل ضرب المصفوفات وهي العملية الأكثر تكراراً في التعلم العميق. لكن معمارية GPU أكثر عمومية؛ بينما بناء معمارية أكثر تخصصاً يمكن أن يُسرع عمليات تدريب نماذج الذكاء الاصطناعي و يوفر أيضاً في الطاقة المستهلكة. ولهذا قامت غوغل بتطوير هذه الوحدات لاستخدمها في تدريب وتشغيل النماذج الكبيرة حيث تبرز أهميتها في زيادة السرعة وتوفير الطاقة بشكل أكبر مقارنة باستخدام GPU.

وبهذا تستكمل غوغل بناء نظام بيئي متكامل للذكاء الاصطناعي بدءاً بالتطبيقات والنماذج وإطار العمل وصولاً إلى البنية التحتية التي تشغلها مما يجعلها لاعباً أساسياً يسيطر على كل ما يحتاجه تطوير ذكاء اصطناعي فعال.

أنواع وحدات TPUs وتطورها

هناك ثلاثة أنواع من الوحدات التي تطورها غوغل؛ الأكثر كفاءة تلك التي تستخدمها في خدماتها السحابية ثم تأتي الأصغر المستخدمة في الأجهزة الطرفية أو تلك المدمجة مع وحدات المعالجة المركزية في هواتف بيكسل.

1- الـ TPUs السحابية

حتى الآن تم تطوير 5 أجيال منها. وقد بنتها غوغل لتدريب أنظمتها داخلياً ثم جعلتها متاحة للاستخدام عبر خدماتها السحابية لكن لا يمكن شرائها وتشغيلها خارج غوغل.

- الجيل الأول عام 2015: كان هذا هو التصميم الأولي لـ TPU، وتم استخدامه بشكل أساسي للبحث والتطوير الداخلي في غوغل.

- الجيل الثاني عام 2017: جلب الجيل الثاني تحسينات في الأداء والكفاءة، وكان أول جيل يتوفر بشكل محدود على خدمات غوغل السحابية.

- الجيل الثالث 2018: قدم هذا الجيل قفزة كبيرة في الأداء وكان أول جيل متاح على نطاق واسع للاستخدام على خدمات غوغل السحابية.وتم لأول مرة تقديم معمارية جديدة تسمى TPU Pod والتي تضم مجموعة من شرائح TPU تعمل معاً.

- الجيل الرابع 2021: يعد قفزة أخرى في الأداء والكفاءة، حيث قدم الجيل الرابع من TPU أيضًا وحدات TPU v4 Pods أكثر كفاءة من الجيل السابق.

- الجيل الخامس 2023: أحدث جيل من الـ TPU، يوفر V5 مكاسب كبيرة في الأداء والكفاءة قد تصل لثلاثة أضعاف الجيل السابق في بعض النماذج مثل نماذج اللغة الكبيرة.

2- الـ TPUs الطرفية

وهي وحدات TPU صغيرة مصممة خصيصاً لتشغيل نماذج الذكاء الاصطناعي على الأجهزة الصغيرة والمحمولة مثل الكاميرات وأجهزة الاستشعار ليتم معالجة الإشارات التي تتلقاها بسرعة وكفاءة. وتم الإعلان عنها عام 2018 تحت اسم Edge TPU وبدأ استخدامها عام 2019 في عدد من الأجهزة الطرفية تحت العلامة التجارية Coral.

3- الـ TPUs المدمجة

تكون هذه الوحدات مدمجة مع معالجات الـ CPU في شريحة واحدة، وهي أقل كفاءة من وحدات TPU الطرفية، لكنها تستهلك طاقة أقل. تم تطويرها خصيصاً لأجهزة الهاتف المحمول لتسريع عمليات الذكاء الاصطناعي، مثل التعرف على الوجه والصوت والصور، والتي أصبحت جزءاً لا يتجزأ من نظام التشغيل والتطبيقات العديدة. وأحدث هذه الوحدات هو Tensor G2، وهو عبارة عن شريحة مصممة خصيصاً لهواتف Pixel، وتجمع بين عناصر TPU ووحدة المعالجة المركزية (CPU) ووحدة معالجة الرسومات (GPU). تم تصميمه لتقديم أداء وكفاءة محسّنين لمهام التعلم الآلي على هواتف Pixel.

من ينافس الـ TPUs؟

تستخدم الخدمات السحابية المنافسة لجوجل مثل أمازون ومايكروسوفت وحدات GPU من انفيديا التي تناسب مهام الحوسبة المختلفة ولا تقتصر على التعلم العميق. لكن المنافس المباشر للـ TPUs هو أنظمة خادم مُصممة خصيصاً للتعلم العميق من انفيديا تسمى DGX (Deep Learning Graphics eXchang). تدمج هذه الأنظمة وحدات معالجة الرسومات عالية الأداء مع مكونات الشبكات والتخزين المحسنة لإنجاز متطلبات التعلم العميق.

وتستخدم أيضاً الشركات مثل مايكروسوفت وميتا وحدات متخصصة من تصنيعها ولكن لا يبدو أنها تشكل الجزء الأكبر من بنيتها التحتية ومازالت تعتمد على منتجات انفيديا بشكل أساسي.

رغم أن غوغل تتيح عبر خدماتها السحابية استخدام GPU من انفيديا وتقول أنها تفعل ذلك لتلبية رغبات مستخدميها ولأن هذه الوحدات تناسب النماذج الصغيرة الحجم لكنها لا تشتري DGX ولاتتيحها بشكل مباشر عبر خدماتها السحابية.

نقاط الضعف في الـ TPUs

من أبرز نقاط الضعف في هذه الوحدات هو تخصصها وزيادة تخصصها في تدريب مجموعة معينة من نماذج الذكاء الاصطناعي وبالتالي فهي معرضة لتصبح قليلة الفائدة و يجب استبدالها كلما حدث تطور في بنية النماذج. وبهذا فعمر الاستخدام الفعال لها مرتبط بشكل مباشر بتطور النماذج والتي غالباً تشهد تغيرات مستمرة ولأن غوغل تصنع أعداد هائلة منها لتشغيل الأنظمة الذكية فاستبدالها ليس بالأمر السهل.

ماهو مستقبل الـ TPUs؟

تعد هذه الوحدات أحد المكونات الأساسية للنظام المتكامل للذكاء الاصطناعي في غوغل ولذا ستستمر غوغل في تطويرها لزيادة فعاليتها سواء من حيث عدد العمليات الحسابية التي يمكن لها أن تجريها -مع خفض استهلاكها للطاقة- أو من حيث زيادة تخصصها لتسريع عمل نماذج محددة كنماذج اللغة الكبيرة أو توليد الصوت أو الفيديو.