حققت نماذج التعلم العميق الكبيرة (مثل ChatGPT و Gemini و DeepSeek و Grok) تقدماً هائلاً في قدرات الذكاء الاصطناعي على الفهم والاستجابة، إلا أن حجمها الهائل يستهلك موارد حاسوبية ضخمة، مما يرفع تكلفة استخدامها.

لهذا تسعى الشركات جاهدة للحفاظ على قوة هذه النماذج مع تصغير حجمها لخفض التكاليف وتسهيل استخدامها. وهنا تبرز تقنية تقطير المعرفة.

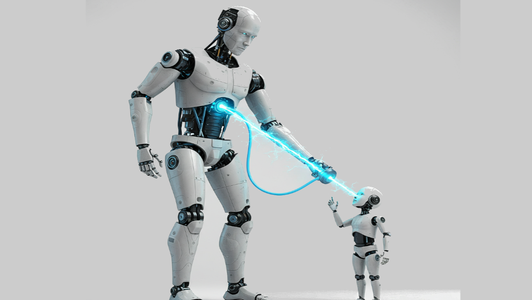

تقطير المعرفة هو عملية نقل المعرفة من نموذج كبير ومعقد (المُعلِّم) إلى نموذج أصغر وأكثر كفاءة (الطالب). في هذا السياق، يقوم المهندسون ببناء نموذج صغير، ولا يعتمدون في تدريبه بشكل كامل على البيانات التي دُرِّب عليها النموذج الكبير. بل يستخدمون مخرجات النموذج الكبير في تدريب النموذج الصغير. وبهذه الطريقة، يستفيد النموذج الصغير من المعارف الضمنية في النموذج الكبير، والتي تتجاوز أهميتها بيانات التدريب، حيث يتعلم محاكاة إجابات المُعلِّم بدلاً من تطوير فهم أعمق بنفسه، مع تحقيق كفاءة أكبر في استخدام الموارد الحسابية

تستفيد الشركات من هذه التقنية في تقديم نماذج ذكاء اصطناعي مُقطَّرة، مما يتيح للمستخدمين تشغيلها على أجهزتهم مباشرة. كما يساعد الشركات عند استخدامها في تقليل التكلفة وزيادة سرعة استجابة تطبيقات الذكاء الاصطناعي للمستخدمين.

بالإضافة إلى ذلك، يمكن استخدام هذه النماذج مباشرة على أجهزة المستخدمين وتشغيلها بكفاءة دون الحاجة إلى اتصال شبكي ونقل المعلومات عبر الإنترنت، الأمر الذي يحافظ على خصوصية المستخدم.

لكن بالطبع، لن يكون النموذج المُقطَّر (أو الطالب) مماثلاً لقدرات النموذج المُعلِّم بشكل كامل؛ فهناك فقدان في بعض المعرفة نظرا لصغر حجمه، مما قد يحد من قدرته على استيعاب عمق المعرفة الموجود لدى المُعلِّم. وقد يواجه صعوبات أكبر في الحالات التي لم يتم تدريبه عليها بشكل كافٍ، مما يؤدي إلى انخفاض قدرته على تعميم المعرفة.

كما أن تدريب النموذج المُقطَّر ليعمل بكفاءة عالية هو عملية مكلفة أيضاً، وقد لا يكون مجدياً في العديد من الحالات.

على الرغم من هذه التحديات، إلا أن تقطير المعرفة يعتبر أساسياً في بناء الذكاء الاصطناعي وانتشاره واستخدامه، فهو يضمن وصولاً سهلاً وسريعاً لأحدث وأقوى نماذج الذكاء الاصطناعي باستخدام موارد أقل. ولهذا يواصل الباحثون والشركات تحسين استراتيجيات التقطير، مما يضمن زيادة كفاءة نماذج الذكاء الاصطناعي المُقطرة مع تقليل الفارق المعرفي مع المعلم.